HomeLab升级笔记

上次写blog还是上次。已经5年没写文章了。本篇文章主要讲讲我HomeLab的设备硬件升级的网络适配篇。主要突出一个能耗与省钱,all in two。

硬件

HomeLab搭起来的时候还是2020年5月,当时选了贵出天际的E3-1235Lv5【对我就是大冤种,这里贴一下现在这台NAS上跑的装备购买日期和花销

| 设备 | 数量 | 单价(RMB) | 购买日期 |

|---|---|---|---|

| E3-1235Lv5/8G/U-NAS八盘位/Asrock ITX C236 WSI | 1 | 3300 | 2020/4/27 |

| 16G ECC UDIMM 2400MHz | 2 | 560 | 2020/4/28 |

| HGST_HUS728T8TALE6L4 8T | 3 | 1169.65 | 2020/4/29 |

| ST4000VN008-2DR166 4T | 2 | 812.52 | 2020/4/29 |

| x16拆分HPE 530双口10G NVMe x2 | 1 | 334 | 2022/1/24 |

| 980 1TB | 2 | 673.49 | 2022/4/13 |

| TPM2-S | 1 | 68 | 2023/6/6 |

最近升级了下HomeLab的硬件配置,主要是平时工作需要开一堆测试环境,1235Lv5 4C4T的可用CPU资源低的可怜,32G的内存开了16G给freenas以后就剩下16G可以开虚拟机,也是到处捉襟见肘,众所周知vCenter跑起来咋说也得12G内存,这玩意跑在之前的HomeLab上还是太痛了。于是买了tank家的D-1581。

| 设备 | 数量 | 单价(RMB) | 购买日期 |

|---|---|---|---|

| Mellanox OCP 单口10G | 1 | 119 | 2022/1/24 |

| 980 Pro 2TB | 1 | 1049 | 2023/4/17 |

| Tank6盘位机箱电源套装 | 1 | 1039 | 2023/9/6 |

| Tank D-1581 板U套装 | 1 | 669 | 2023/9/6 |

| 32G SK RECC 2666MHz | 4 | 190 | 2023/9/7 |

由于这个主板不支持独立TPM,另外功耗也稍微高一点,这两个设备算是优势互补了,所以要把这两个设备都用起来。从垃圾山里掏出了当年买的坏过一次的nvme MLC 256G ssd用作系统盘,这东西购买日期太久远了,价格可以忽略不计了。不得不吐槽一下国产之光长江存储是真的生猛,现在4T的pcie4 NVME都可以1032块拿下,太离谱了。我再等等,反正现在存储需求增长稳定,没啥大量新增的需求,估计能等到SATA的ssd铺货组全闪NAS。

网络拓扑

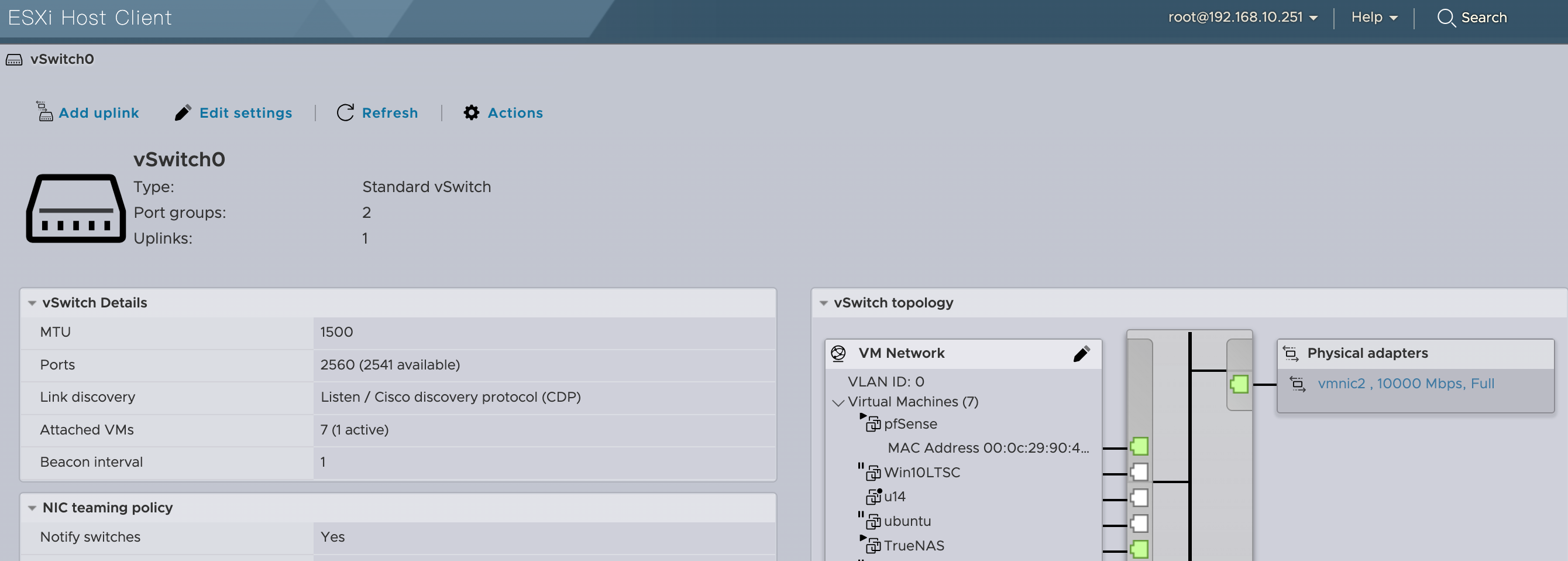

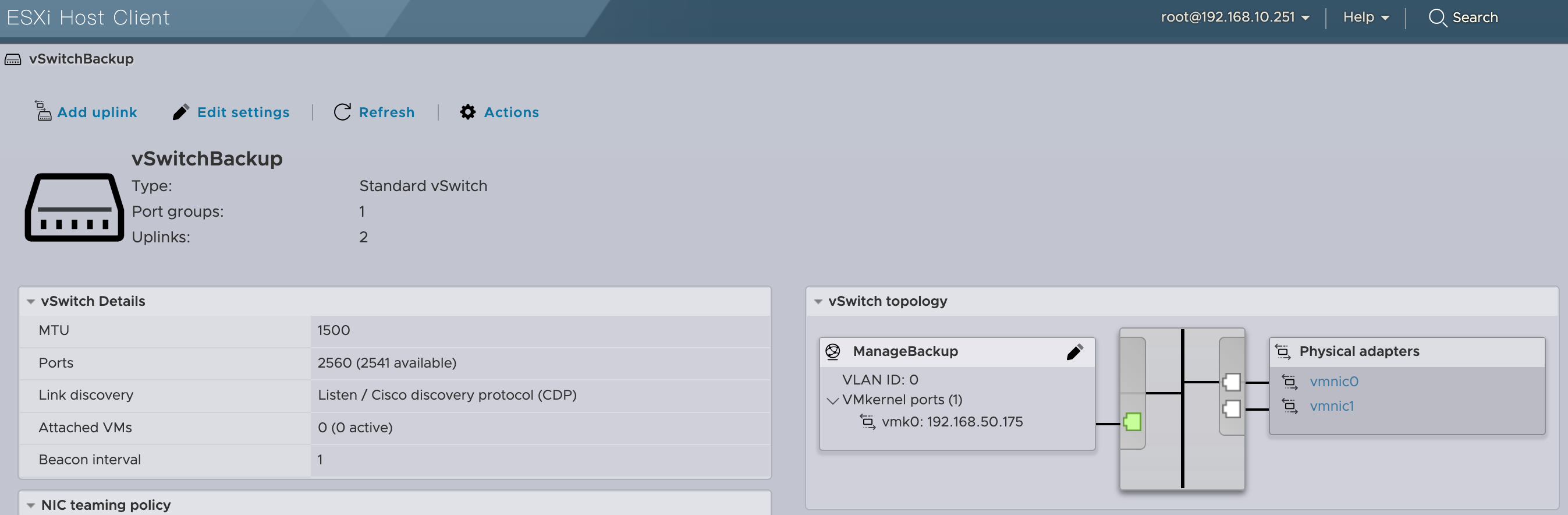

Machine1 1235Lv5

主板上有两个1GbE口,就用作万一网坏了的情况下的备胎口

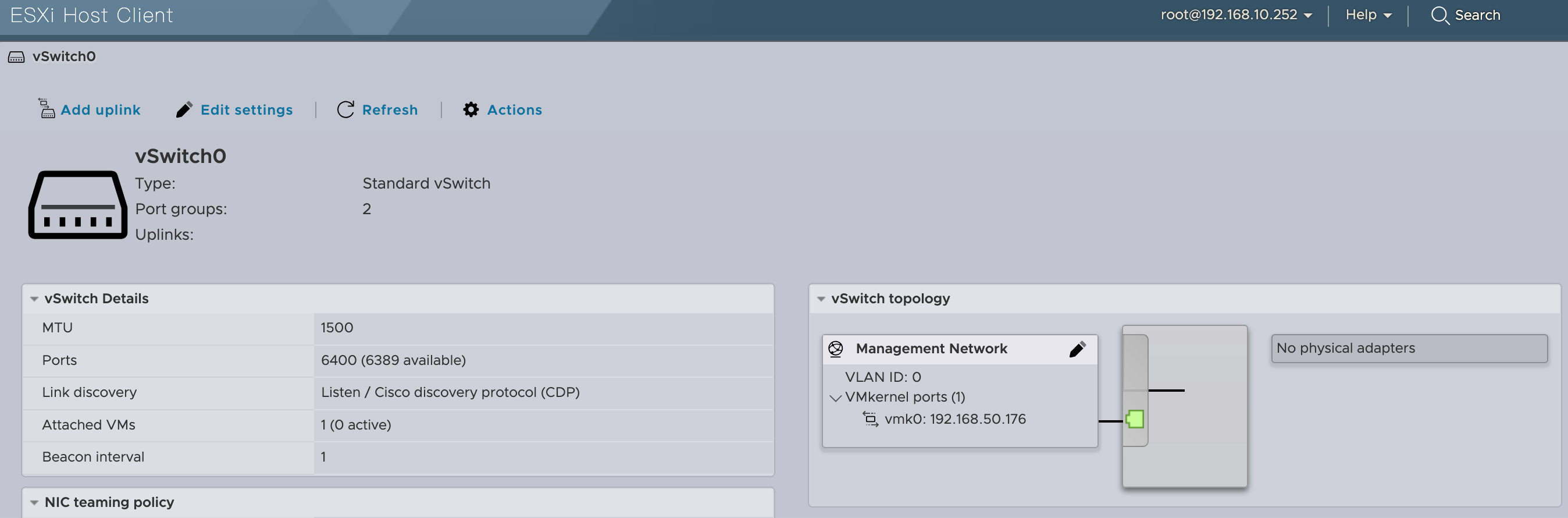

Machine2 D-1581

因为我把usb网卡拔了所以没有uplink,有临时需要插上去就可以了

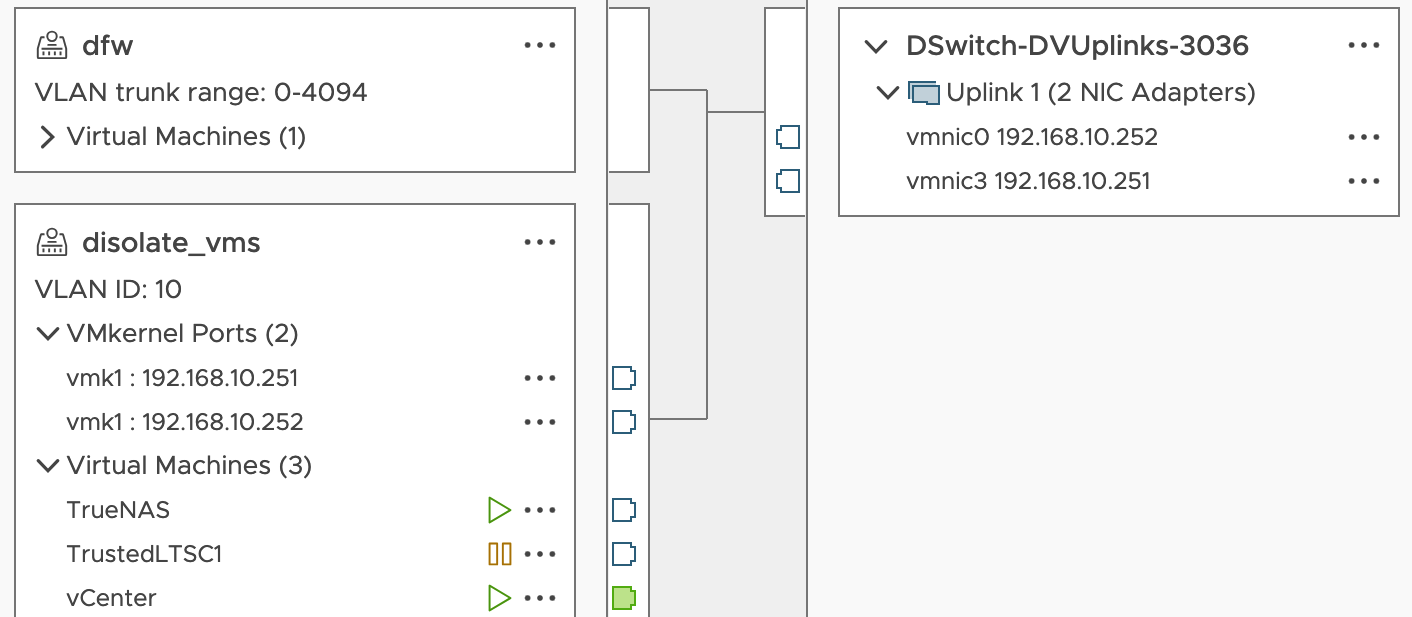

Distributed vSwitch

其中TrueNAS是在Machine1的,vCenter是在Machine2的。配置方法后面再展开说。

ESXi 7

首先,ESXi6.7 已经彻底EoL了,退一步用ESXi6.7从而利用上D1581主板的3个2.5GbE肯定是行不通的,这风险我是承担不起,虽然能通过运维手段把这玩意塞到封闭网段尽量降低被日可能性,但是被打出虚拟机逃逸的可能性依然不是0,那就还是算了。

1 | To help customers with that transition, we are extending the general support period for vSphere 6.7. Originally, vSphere 6.7 was scheduled to reach EoGS (End of General Support) on November 15, 2021. We are extending this date by 11 months, to October 15, 2022. |

那么要解决的问题就是如何用一张单口OCP10G卡和双口10G HPE530达成跨两个设备的实验环境组网。

Fling USB Network Native Driver for ESXi

因为Realtek Semiconductor Co., Ltd. RTL8125 2.5GbE Controller 在6.7以前是通过vmklinux兼容层实现的,这个在7被从kernel里删除了。

1 | That depends on whether the driver type is “vmklinux” or “native” as the support for “vmklinux” drivers was removed in ESXi 7. |

所以只能退一步用Fling的USB网卡。但是用了一天发现这东西十分不稳定,我也不知道是不是因为太热了,只要数据传输量大了时间长了他就直接掉设备摆烂,那这玩意就只能作为一个网卡的备份,如果临时有需求了再插上去。

1 | 2023-09-15T14:55:47.593Z cpu12:2097798)WARNING: vmkusb_nic_fling: udev 0x430e91281248, endpoint 0x82: invalid state 5: Failure |

可以从这里下载

https://flings.vmware.com/usb-network-native-driver-for-esxi

安装说明也在上面的链接里

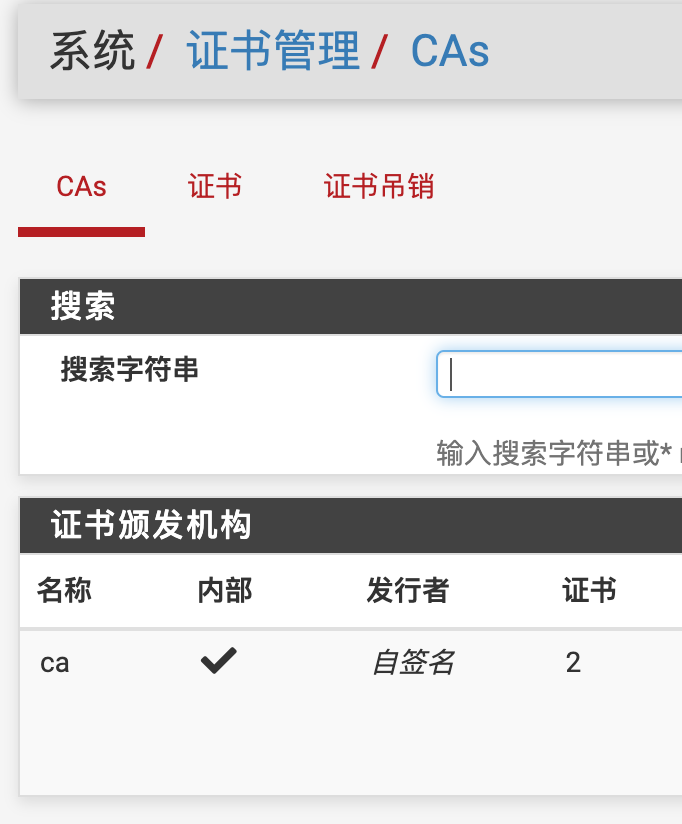

pfSense

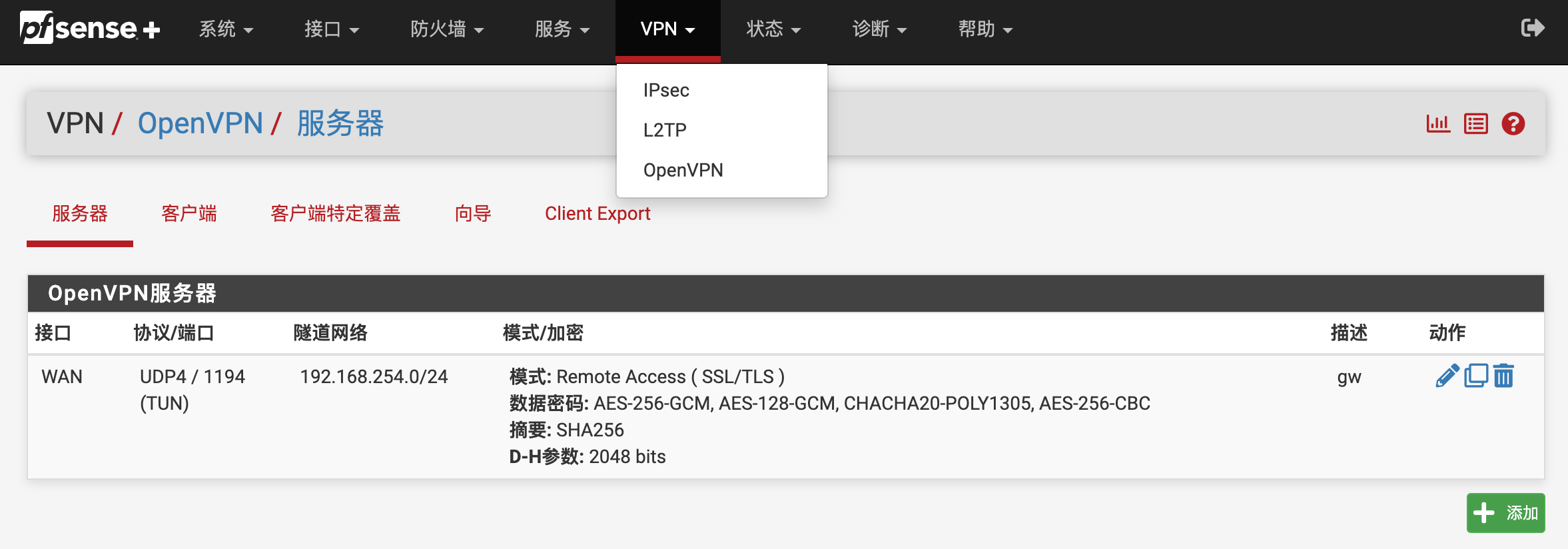

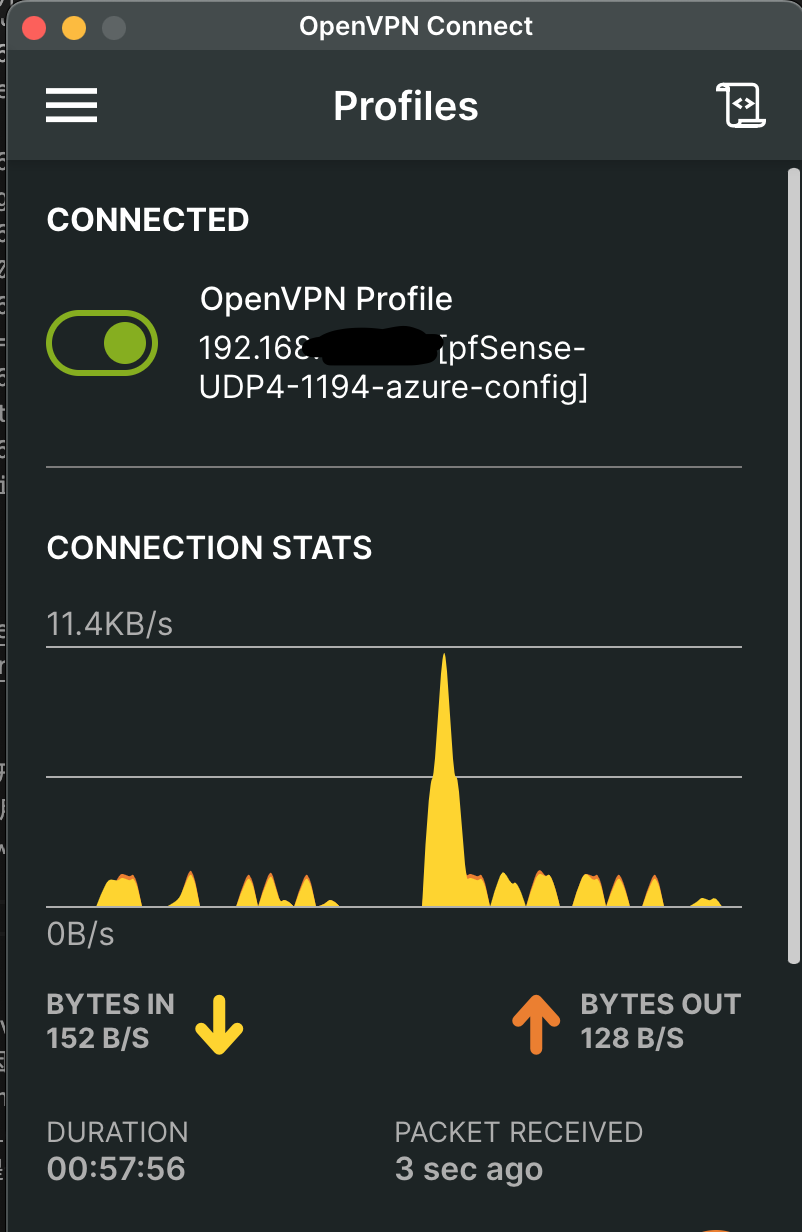

用来暴露在外面,比之前新开了一个openvpn的服务,这样可以从家里连到这里面直接操作里面的ip,就用不着额外再开一台vm做转发了。也不用每开一台vm就需要额外加一条forward规则,nat规则太多到最后自己都记不住哪个端口是哪台机器的。

pfsense自带openvpn server,用起来还是挺方便的。

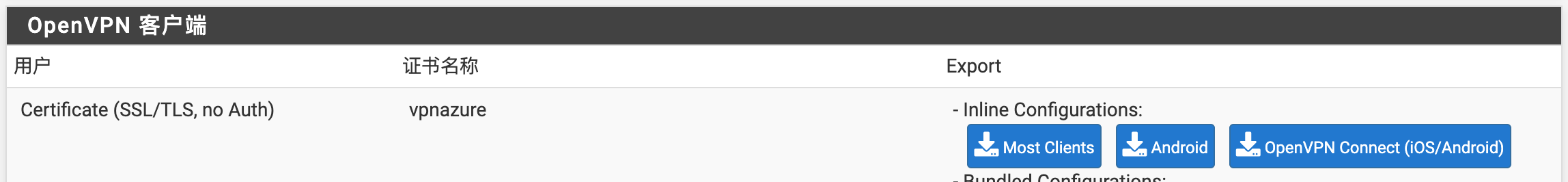

openvpn生成配置里需要改的两个地方是IPv4隧道网络和IPv4本地网络我这里分别是192.168.254.0/24和192.168.0.0/16。可以选择使用向导生成然后把验证方式改成TLS only【一个人用搞什么ACL控制

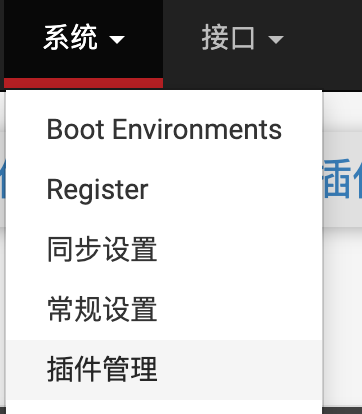

这里需要去插件里面装一个openvpn-client-export的插件,要不然没法生成配置。

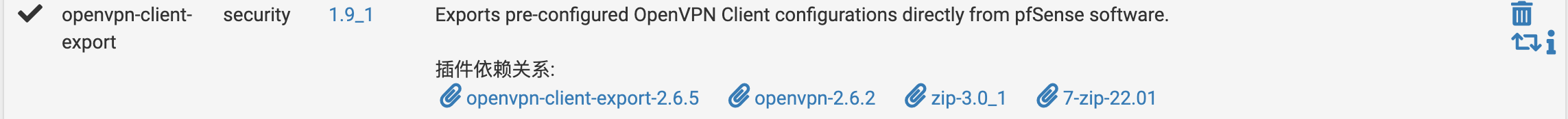

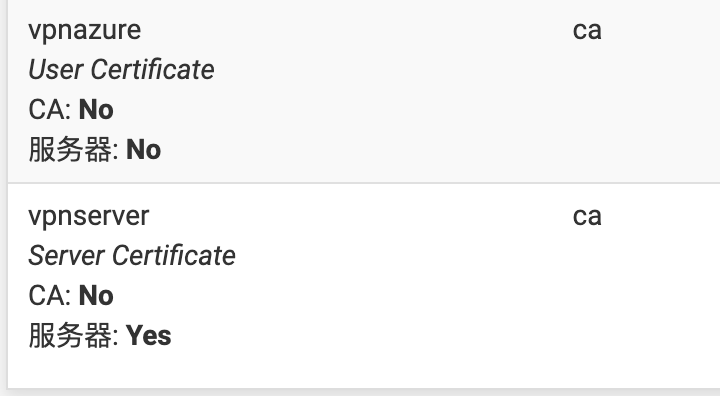

证书这边,需要一个ca,然后用这个ca签两个证书,一个是server的一个是client的

然后VPNServer配置那边关联一下ca签出来的server的证书,这个时候再去看client export就有个可以导出的client证书了

防火墙那边记得放通WAN对应的UDP端口和OpenVPN interface的流量。

下载下来就可以直接用了。

TrueNAS scale

监听两个IP,一个在1235Lv5的Bridge区,一个在vSwitch的trusted vlan。监听俩IP的主要原因是pfsense的NAT转发效率低下,我最多就只能跑到140MB/s,但是同vlan下能跨两个设备的VM传输SMB数据能跑到700MB/s,对我来说足够用了。Bridge区的IP可以不监听ssh,把ssh开到trusted的vlan上。这样安全性又提升了。

vCenter 7

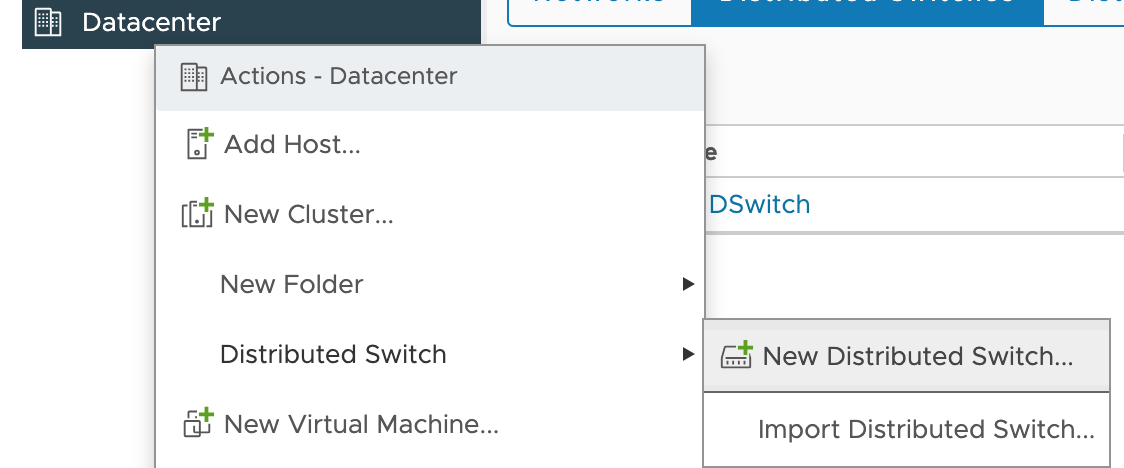

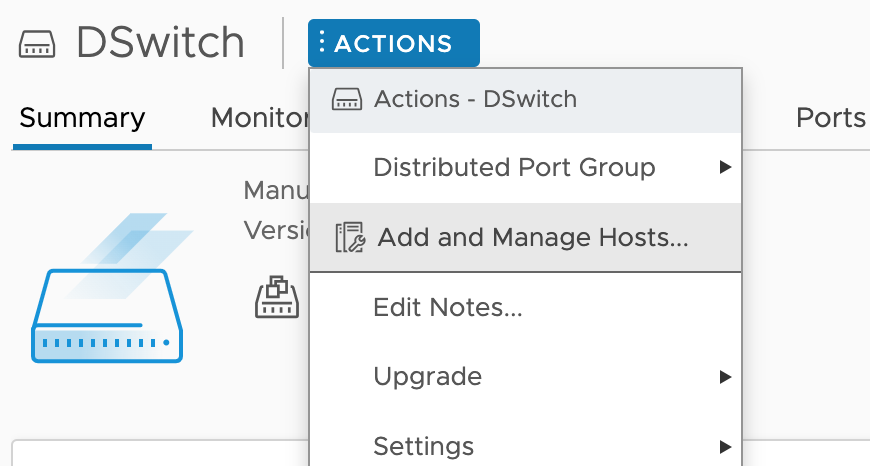

在datacenter里添加一个Distributed Switch

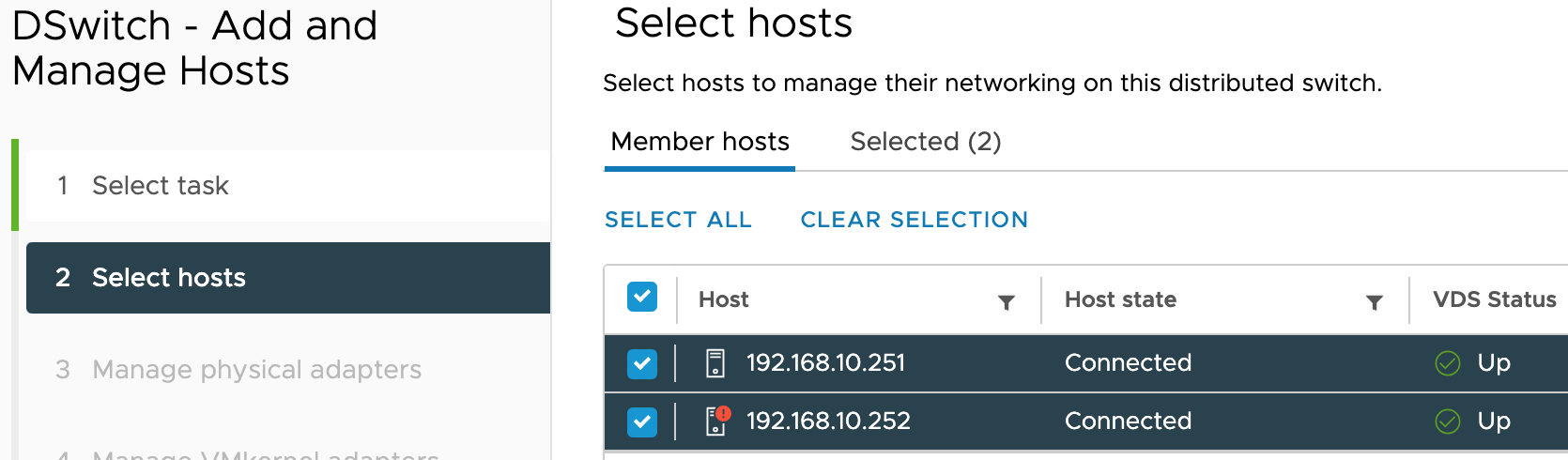

两台机器网卡不一样,推荐一个一个添加,这样不容易搞混,最终成品就是参考上面拓扑图

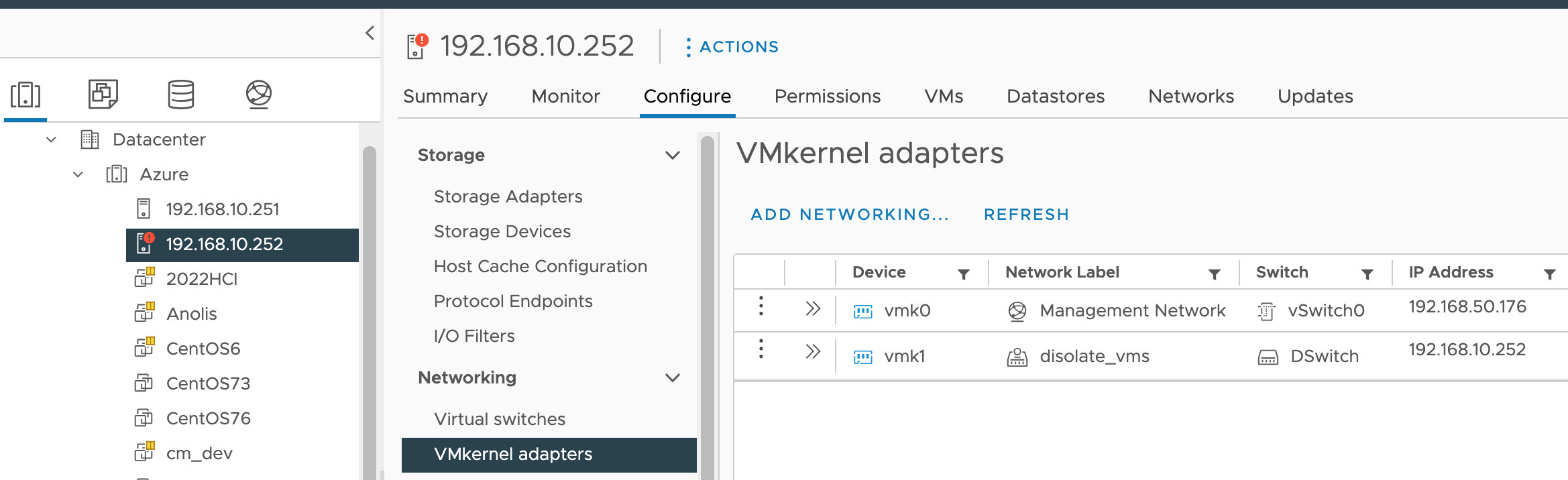

然后到两台机器到的configure页面给这边添加一个新的vmkernel卡,然后把它连到分布式虚拟交换机(Distributed vSwitch)的trusted vlan里

这样vcenter/esxi1/esxi2的管理IP就全都收到了trusted vlan里,可以通过先拨vpn再访问的方式进行管理【安全性又上了一个台阶。

总结

至此硬件软件升级都已完成,两台esxi间是万兆互联,外部连machine2的vm速度也不含糊。是躺着测速的时候了。

machine2 vm-> machine1 vm

1 | Connecting to host 192.168.10.2, port 5201 |

machine2 vm-> pfsense -> machine1 vm

过了一层nat性能直接打2折,有点离谱,但也算正常,想不到啥简单的优化方法,难道能在mtu上做点文章?毕竟vlan多一个802.1q的头,估计包重组了,反正我给pfsense加cpu是没效果的,懒得看了。这也够用了,毕竟外网带宽也就跑到1.2Gbps。

1 | Connecting to host nas, port 5201 |

碎碎念

为什么不是ESXi8

- 因为ESXi8把ConnectX3支持干掉了,至少也得上ConnectX4lx的卡。有机会再续吧,毕竟ESXi7的EoL要到2027年4月了,到时候估计网卡的价格也下来了,能不能有家用40G/100G呢?除非那个时候电费打骨折了,要不然我还要考虑下能效问题,毕竟10G的日常体验已经非常不错了。

为啥这么久没写文了

- 过去几年发生的事情太多了,写文还是太浪费时间了。就是生活图个乐子吧,希望想抄作业的同学看完能少走些弯路。